― DeepSeek、Huawei、AMD、そしてNVIDIAの力学

AI推論性能のベンチマークをオープンに可視化する新興プロジェクト「InferenceMAX」が登場し、

AI業界に新たな透明性をもたらし始めている。

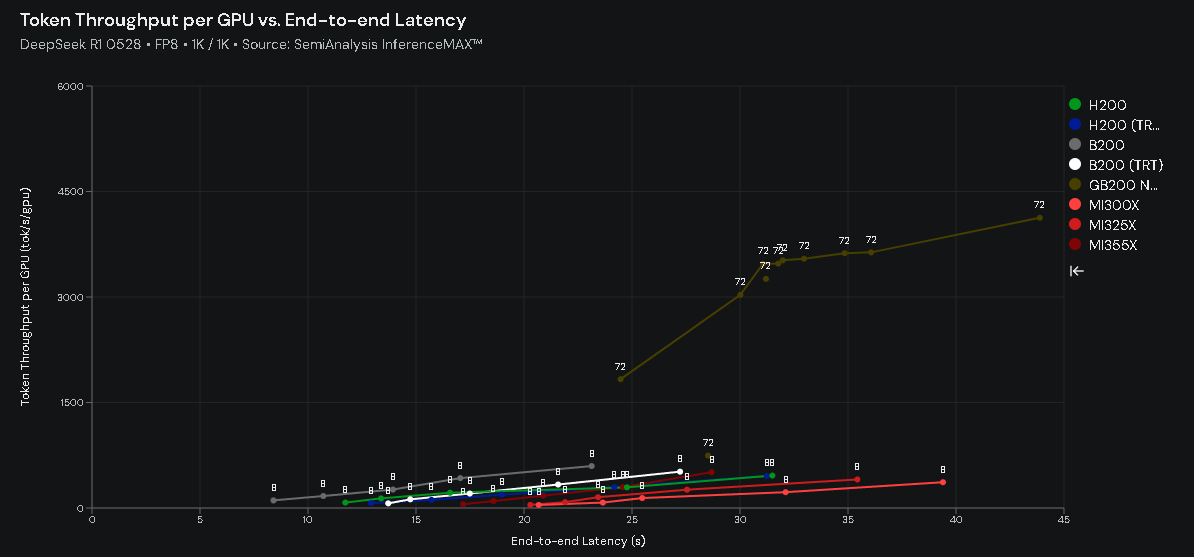

同プロジェクトでは、「gpt-oss 120B」「DeepSeek R1 0528」「Llama 3.3 70B Instruct」 の3モデルがテスト対象として採用された。

結果として、DeepSeekが3モデル中で最も低い性能を示すという興味深いデータが得られている。

単なるスコア比較にとどまらず、この結果はAI半導体のサプライチェーン構造と最適化戦略の現実を映し出している。

DeepSeekが直面する「構造的な制約」

DeepSeekは中国の新興スタートアップであり、アリババやテンセントのような巨大資本を持つ企業ではない。

そのため、開発インフラは主に NVIDIA H200 GPU を中心に構築されてきたと考えられる。

一方、「gpt-oss 120B」や「Llama 3.3 70B Instruct」 は、

より新しい Hopper(H100/B200)世代 のGPUや、

広範な最適化が施された環境でテストされており、

単純な性能比較では本質を見誤るおそれがある。

実際、「DeepSeek R1 0528」のInferenceMAXの性能曲線を見ると、

H200世代をメインターゲットとした最適化傾向を示している一方で、

「gpt-oss 120B」や「Llama 3.3 70B Instruct」は明らかに異なる特性を示す。

このことから、NVIDIAの最新アーキテクチャに最適化されたモデル群とDeepSeekとの間に明確な隔たりがあることがわかる。

Huawei Ascendへの移行が意味するもの

DeepSeekは現在、Huawei(ファーウェイ)のAscendチップ上での再構築を進めていると報じられている。

この選択は単なる技術的判断ではなく、地政学的およびサプライチェーン上の必然でもある。

米国による輸出規制によって、中国企業は高性能NVIDIA GPUへのアクセスを制限されており、

Ascendは「中国独自のAIインフラを支える要」として急速に位置づけを高めている。

ただし、Ascend環境に注力するということは、

今後もNVIDIA向け最適化の優先度が下がり続けることを意味する。

したがって、DeepSeekの現行ベンチマーク結果は「技術力の不足」ではなく、

リソース配分上の構造的制約として理解すべきだろう。

成長する運用コストの現実

ベンチマークからはもう一つ重要な示唆がある。

DeepSeekは初期投資段階でNVIDIA GPUコストを抑えられる可能性があるものの、

運用フェーズではコストが膨らみやすい構造を持っている。

H200世代GPUをベースとするシステムでは、

同等の性能を出すためにより多くのGPUノードを必要とする傾向があり、

その結果、電力消費・冷却・ラックスペース・データセンター運営コストなど

TCO(総保有コスト)が増大しやすい。

DeepSeekがAscend環境への移行を急ぐのは、

単なる「政治的リスク回避」ではなく、運用効率化の観点からも合理的な判断といえる。

比較の次のステージ:中国勢「Qwen 3」への期待

DeepSeekは衝撃的な登場で注目を集めたものの、

技術リソースの配分上、NVIDIA最適化の優先度が低いと推測される。

次のステップとして、「InferenceMAX」の検証対象に**「Qwen 3」**などの

中国勢LLMモデルを加えることで、

維持コスト・推論効率・アーキテクチャ特性の国際比較がより明確になるだろう。

これにより、中国のAI企業がどのようにNVIDIA依存から脱却し、

自国チップで推論基盤を構築しつつあるかが可視化される。

AI競争は「パラメータ数」ではなく、

電力効率(Performance per Watt)とインフラコスト最適化力の勝負に移行しつつある。

AMDとNVIDIA:性能差の再定義

今回のInferenceMAXの結果を見ると、

AMDのGPUも着実に存在感を高めている。

特に「gpt-oss 120B」では、AMD環境での最適化が功を奏し、

NVIDIAとの性能差が大きく縮小している。

一方で、「Llama 3.3 70B Instruct」では、

B200とMI355の間に約2倍の差が見られた。

この差はハードウェアの性能よりも、

ソフトウェアスタック(CUDAエコシステム)の成熟度の影響が大きい。

AMDは今後、PyTorch 2.x / ROCm / Transformersベースの最適化を進め、

性能差の縮小と同時にコスト優位性の確立を狙っている。

今後の展望:マルチチップ時代への分岐点

「InferenceMAX」は今後、Google TPU や Amazon Trainium にも対応予定だという。

これが実現すれば、AIチップ市場はついに「NVIDIA一強」から

マルチベンダー最適化競争の時代へと移行するだろう。

各クラウドベンダーは自社インフラを

電力効率・推論スループット・コスト効率の三軸でチューニングし、

性能と経済性の両面で競い合う構図になる。

「InferenceMAX」が日次で公開するオープンデータは、

AI企業の技術判断だけでなく、投資家・クラウド事業者・政策研究者にとっても

極めて価値の高い指標になると考えられる。

総括:地政学・経済・技術が交差する新たなフェーズへ

DeepSeekの性能が他社より低いという結果は、

単なる「劣後」ではなく、自国チップによるAI推論の自立化に向けた

壮大な試行の一部と見るべきだ。

AIチップ競争は、もはやハードウェア単体の性能競争ではない。

地政学、エネルギー、経済、そしてオープンソース戦略が交錯する総合戦の様相を呈している。

そして「InferenceMAX」は、

そのダイナミクスを可視化する新しい分析レンズとして、

今後のAI産業インサイトを読み解く上で欠かせない存在になるだろう。

コメントを残す